Maîtriser le Modèle de Conception SAGA dans les Architectures de Microservices

Dans le monde actuel des architectures distribuées, gérer des transactions qui s’étendent sur plusieurs microservices est l’un des plus grands défis. C’est là qu’intervient le Modèle SAGA, une solution clé pour garantir la cohérence éventuelle dans les systèmes distribués.

Qu’est le modèle SAGA ?

Le modèle SAGA est une approche de gestion des transactions distribuées dans les architectures de microservices. Au lieu d’utiliser une transaction unique qui verrouille des ressources dans tous les services impliqués, comme dans l’approche traditionnelle du Two-Phase Commit (2PC), le modèle SAGA divise la transaction en une séquence d’étapes ou de sous-transactions, chacune ayant une action de compensation en cas d’échec.

Qu’est le Two-Phase Commit (2PC) ?

Le Two-Phase Commit (2PC) est un protocole utilisé pour garantir une forte cohérence dans les transactions distribuées. En 2PC, une transaction impliquant plusieurs nœuds ou services suit deux phases :

- Phase de préparation : Tous les participants reçoivent une demande de préparation, et chacun répond s’il peut ou non valider les modifications.

- Phase de commit : Si tous les participants sont prêts, une demande de validation leur est envoyée pour confirmer les changements. Si l’un d’entre eux ne peut pas terminer l’opération, un rollback est initié pour annuler les modifications. Le 2PC assure une forte cohérence, mais peut verrouiller les ressources pendant de longues périodes, ce qui est problématique dans les systèmes distribués nécessitant une haute disponibilité et une grande scalabilité.

Comment fonctionne le modèle SAGA ?

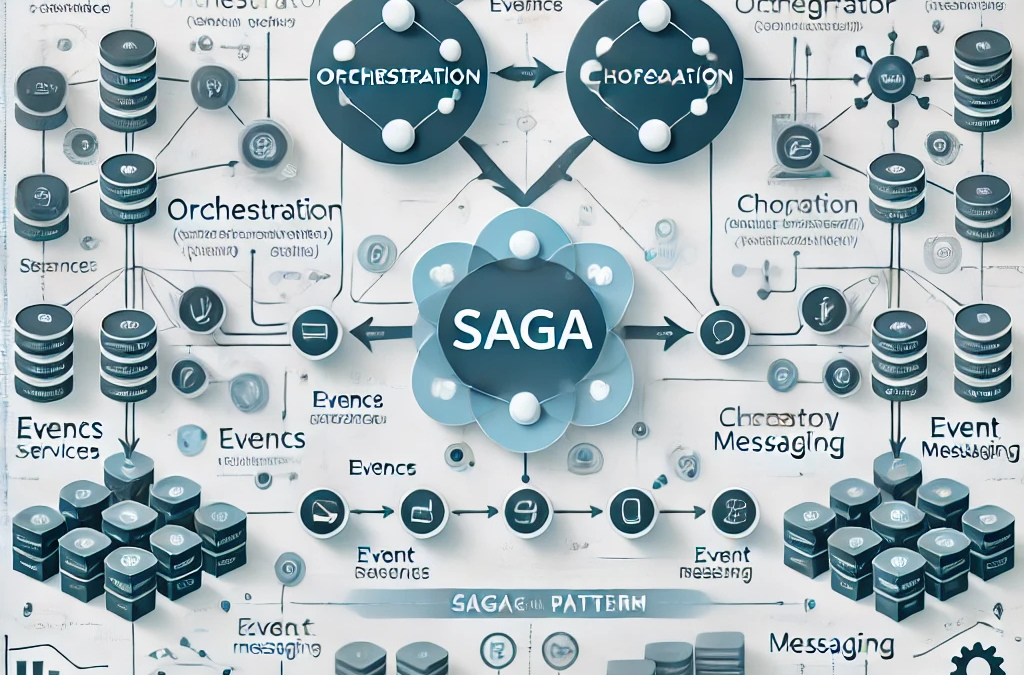

Le modèle SAGA offre une alternative au 2PC en divisant une transaction en sous-transactions plus gérables, chacune ayant des actions de compensation pour les cas où une étape échoue. Il existe deux principaux types de SAGA : Orchestration et Chorégraphie, selon que le flux est contrôlé de manière centralisée ou de manière autonome par chaque service.

Pourquoi adopter le modèle SAGA ?

Les principaux avantages du modèle SAGA sont :

- Robustesse : Améliore la capacité du système à se remettre des échecs en permettant des compensations efficaces.

- Scalabilité : Il n’est pas nécessaire de verrouiller les ressources, ce qui permet une plus grande scalabilité des microservices indépendants.

- Désaccouplement : Permet aux services de fonctionner de manière autonome, facilitant l’évolution du système.

Comment implémenter le modèle SAGA ?

Pour implémenter des Sagas :

- Identifier les microservices : Définir les services participant à la transaction.

- Définir des sous-transactions et des compensations : S’assurer que chaque service dispose d’une action de compensation.

- Orchestration ou Chorégraphie : Choisir l’approche adéquate en fonction de la complexité.

- Utiliser des frameworks : Les outils peuvent faciliter la mise en œuvre des Sagas.

Outils pour implémenter le modèle SAGA

Il existe de nombreux outils qui simplifient la mise en œuvre des Sagas dans des architectures distribuées :

Bibliothèques et Frameworks

- Spring Boot

- Spring Cloud Stream : Facilite l’intégration des microservices avec une approche chorégraphique.

- Spring Cloud Kafka Streams : Utile lorsqu’on utilise Kafka comme système de messagerie pour les Sagas.

- Eventuate Tram : Offre une implémentation solide du modèle SAGA, permettant de coordonner des transactions distribuées de manière robuste, compatible avec l’orchestration et la chorégraphie.

- Axon Framework : Connu pour l’Event Sourcing et le CQRS, il est également idéal pour implémenter des Sagas. Son approche basée sur les événements permet une intégration fluide dans les architectures distribuées.

- Camunda : Une plateforme d’automatisation des processus qui gère des flux de travail avec BPMN, idéale pour l’orchestration dans les Sagas.

- Apache Camel : Offre un composant Saga qui facilite la coordination des microservices distribués par le biais de la messagerie.

Services Cloud

- AWS

- AWS Step Functions : Idéal pour les flux de travail distribués, permettant d’implémenter des Sagas par orchestration.

- Amazon SWF : Offre un contrôle plus poussé sur l’état des transactions distribuées.

- Azure

- Azure Durable Functions : Permet d’écrire des flux de travail stateful dans un environnement serverless, idéal pour les Sagas.

- Azure Logic Apps : Fournit une interface visuelle pour concevoir et automatiser des flux de travail.

- Google Cloud

- Google Cloud Workflows : Permet d’orchestrer des services et des APIs pour implémenter des Sagas.

- Google Cloud Composer : Basé sur Apache Airflow, il est idéal pour des flux de travail complexes.

Autres Alternatives

- MicroProfile LRA : Gère des transactions longue durée dans les microservices.

- Temporal.io : Une plateforme open-source pour les flux de travail durables.

- NServiceBus Sagas : Fait partie de la plateforme NServiceBus, spécialisée pour .NET.

Considérations pour le Choix des Outils

Lors du choix d’un outil pour implémenter des Sagas, prenez en compte des facteurs tels que :

- Stack technologique : Choisir des outils compatibles avec la technologie déjà utilisée.

- Complexité : Des outils comme Axon Framework ou Temporal.io sont conçus pour des flux plus complexes.

- Infrastructure : Les options cloud comme AWS Step Functions offrent des solutions gérées, tandis que des outils comme Camunda permettent un contrôle plus poussé sur des serveurs locaux.

- Courbe d’apprentissage : Certaines plateformes nécessitent plus de temps pour être maîtrisées mais offrent une plus grande flexibilité et un meilleur contrôle.

Quand utiliser le modèle SAGA ?

Déterminer quand utiliser le modèle SAGA dépend des caractéristiques spécifiques du système distribué et des exigences des transactions. Le modèle SAGA est idéal pour gérer des transactions distribuées complexes et garantir disponibilité et scalabilité sans bloquer les ressources des microservices impliqués. Voici des scénarios où le modèle SAGA est la meilleure option et ceux où d’autres alternatives peuvent être plus appropriées.

Quand utiliser le modèle SAGA

- Transactions distribuées longue durée : Dans les systèmes où les transactions peuvent s’étendre sur plusieurs services et ne doivent pas verrouiller des ressources pendant une longue période, SAGA est essentiel. En divisant les transactions en étapes indépendantes, on évite de bloquer les ressources dans plusieurs services, ce qui améliore la performance et la scalabilité.

- Haute tolérance aux échecs : Dans les environnements où la robustesse est cruciale, le modèle SAGA permet d’effectuer des actions de compensation en cas d’échec, garantissant que le système se rétablisse rapidement sans affecter la cohérence globale.

- Systèmes désaccouplés : Dans des architectures de microservices où les services doivent fonctionner de manière autonome, la chorégraphie dans le modèle SAGA permet aux services d’interagir via des événements, facilitant l’évolution indépendante de chaque service.

- Scalabilité : Pour des systèmes nécessitant une haute capacité de scalabilité, le modèle SAGA est excellent, puisqu’il ne dépend pas de transactions globales qui bloquent les services, permettant à chaque microservice de traiter ses transactions de manière indépendante.

- Processus métiers complexes : Dans des scénarios où les règles métiers couvrent plusieurs services et nécessitent un contrôle détaillé sur le flux de transaction, l’approche par orchestration dans SAGA offre une vue centralisée et facilite la gestion des erreurs.

Quand ne pas utiliser le modèle SAGA

- Transactions courtes à faible risque : Si les transactions sont simples et ne couvrent pas plusieurs services, utiliser SAGA peut ajouter une complexité inutile. Dans ces cas, il peut être préférable d’utiliser une approche plus simple, comme le Two-Phase Commit (2PC), qui garantit une forte cohérence sans nécessiter la mise en œuvre d’actions de compensation.

- Exigences strictes de forte cohérence : Si le système doit garantir que tous les services impliqués dans une transaction maintiennent un état cohérent à tout moment, le 2PC pourrait être plus approprié. Cela est plus courant dans les systèmes où la disponibilité n’est pas le principal critère et où le blocage temporaire des ressources est toléré pour garantir la cohérence.

- Environnements avec faible tolérance aux échecs transitoires : Dans certains systèmes, les échecs intermittents ou transitoires peuvent être moins fréquents, et la nécessité d’un système mettant en œuvre des compensations peut être surdimensionnée. Pour ces cas, la gestion traditionnelle des transactions peut suffire.

Conclusion

Le modèle SAGA est un outil puissant pour la gestion des transactions distribuées dans les architectures de microservices, offrant robustesse, scalabilité et flexibilité dans des environnements où la disponibilité est essentielle. Cependant, comme tout modèle de conception, son application dépend du contexte. Utiliser SAGA dans des scénarios où les transactions sont complexes et distribuées améliorera la capacité de récupération en cas d’échec et la performance générale du système.

D’un autre côté, dans les environnements où la forte cohérence est essentielle ou lorsque les transactions sont simples et de courte durée, les solutions traditionnelles comme le Two-Phase Commit (2PC) peuvent être plus adaptées. L’essentiel est d’évaluer soigneusement les besoins spécifiques du système avant de choisir la stratégie de gestion des transactions qui convient le mieux aux exigences métier et techniques.